ทำไม AI ต้องใช้ GPU ไม่ใช่ CPU

ทุกวันนี้ปฏิเสธไม่ได้ว่า AI เข้ามามีบทบาทและเป็นหัวข้อที่พูดถึงอย่างทั่วไป ด้วยความสามารถในการคิด วิเคราะห์ หรือประมวลผลข้อมูลจำนวนมาก ออกมาเป็นเนื้อหาที่ผู้ใช้ต้องการได้ภายในไม่กี่วินาที ทำให้ AI กลายเป็นคลื่นลูกใหม่ของวงการเทคโนโลยี

ซึ่งนอกจากผู้สร้างโปรแกรม AI เจ้าต่าง ๆ อย่าง OpenAI (ChatGPT), Google (Gemini), Microsoft (Copilot) แล้ว อีกหนึ่งสิ่งที่ขาดไม่ได้เลยนั่นก็คือตัว Hardware ที่ทำการรันและประมวลผล AI ซึ่งผู้ที่ผงาดขึ้น ในยุค AI แบบแทบจะไร้คู่เทียบเลยก็คือบริษัท NVIDIA ผู้ผลิต "การ์ดจอ" ชื่อดังที่เกมเมอร์รู้จักกันเป็นอย่างดี

แล้วทำไมผู้ผลิตการ์ดจอ ถึงเป็นผู้นำด้าน Hardware ในยุค AI?

คำตอบคือ GPU หรือ Graphics Processing Unit ที่เป็นชิปในการประมวลผลด้านกราฟิกที่อยู่บนการ์ดจอนั่นเอง

แล้วทำไม AI ต้องใช้ GPU ไม่ใช่ CPU ที่เป็นหัวใจหลักในการประมวลผลแบบที่เราคุ้นเคย?

คำตอบก็คือ รูปแบบของการประมวลผล แม้ GPU กับ CPU นั้น เป็นหน่วยประมวลผล เหมือนกัน แต่รูปแบบ ในการประมวลผลนั้นมีความต่างกัน ก่อนอื่นเรามาทำความเข้าใจขุมพลังของ CPU และ GPU เพื่อให้เข้าใจความแตกต่างหลักระหว่างหน่วยประมวลผลทั้งสองนี้กัน

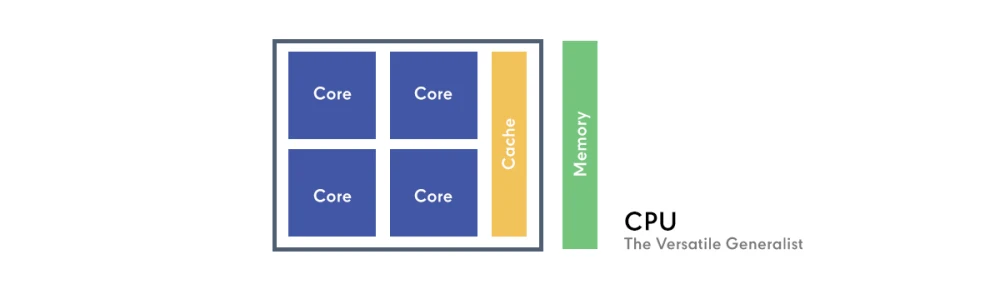

CPU: ผู้เชี่ยวชาญรอบด้าน (The Versatile Generalist)

CPU ถูกออกแบบมาเพื่อความหลากหลาย มันโดดเด่นในการประมวลผลแบบเรียงลำดับ (Sequential Processing) โดยจัดการกับงานที่ซับซ้อนทีละงานด้วยความเร็วและความแม่นยำสูง ลองจินตนาการว่า CPU คือผู้จัดการที่ฉลาดมาก สามารถจัดการกับปัญหาที่ซับซ้อนได้หลากหลายประเภท โดยมุ่งเน้นที่แต่ละงานอย่างเข้มข้นตั้งแต่ต้นจนจบ โดยปกติแล้ว CPU จะมีแกนหรือคอร์ (Core) ที่ทรงพลังไม่กี่แกน ซึ่งถูกปรับให้เหมาะสมกับการตัดสินใจที่ซับซ้อนและปริมาณงานที่หลากหลาย ทำให้เหมาะสำหรับระบบปฏิบัติการ การประมวลผลคำ การท่องเว็บ และการรันแอปพลิเคชันทั่วไป

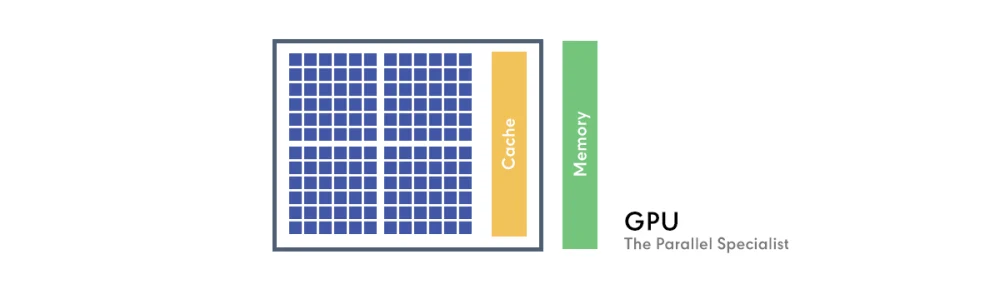

GPU: ขุมพลังการประมวลผลแบบขนาน (The Parallel Specialist)

ในทางกลับกัน GPU ถูกออกแบบมาเพื่อประมวลผลกราฟิก ซึ่งเกี่ยวข้องกับการคำนวณที่คล้ายกันหลายล้านครั้งพร้อม ๆ กัน (เช่น การประมวลผลพิกเซลแต่ละพิกเซลบนหน้าจอ) เพื่อให้บรรลุเป้าหมายนี้ GPU จึงประกอบด้วยแกน หรือ คอร์ขนาดเล็กและมีความเชี่ยวชาญเฉพาะทางนับพันแกน ลองนึกภาพ GPU เหมือนทีมงานขนาดใหญ่ที่มีพนักงานที่มีประสิทธิภาพสูงหลายพันคน แต่ละคนสามารถทำงานง่าย ๆ ซ้ำ ๆ ได้อย่างรวดเร็วพร้อมกันทั้งหมด แม้ว่าพวกเขาอาจจะไม่ได้ "ฉลาด" เท่าผู้จัดการที่เป็น CPU แต่พลังการประมวลผลแบบขนานร่วมกันของพวกเขานั้นไร้คู่แข่งสำหรับงานบางประเภท

ด้วยลักษณะเด่นของการประมวลผลของ GPU นั่นเอง จึงเหมาะกับการทำงานเฉพาะทางพวก Machine Learning และ Deep Learning เพราะการทำงานของปัญญาประดิษฐ์ โดยเฉพาะอย่างยิ่งในโมเดล Deep Learning หรือ โครงข่ายประสาทเทียม (Neural Networks) นั้น มีรากฐานมาจากการคำนวณทางคณิตศาสตร์ที่เรียบง่ายแต่ทำซ้ำ ๆ กันเป็นจำนวนมหาศาล

ส่วนธรรมชาติของ CPU นั้นแตกต่างออกไป CPU เก่งเรื่องการสลับงานที่หลากหลายและซับซ้อน (เช่น เปิดโปรแกรมหลายโปรแกรม, ประมวลผลเอกสาร, รันระบบปฏิบัติการ) โดยใช้คอร์ไม่กี่ตัวที่ฉลาดมากๆ สลับกันไปมา ซึ่งหากนำ CPU มาใช้ประมวลผล AI ที่ต้องทำคำนวณซ้ำ ๆ เป็นล้านครั้ง CPU จะกลายเป็นคอขวดอย่างรุนแรง เพราะมันถูกออกแบบมาให้ทำทีละขั้นตอนอย่างละเอียด ไม่ได้ออกแบบมาเพื่อโยนงานแบบเดียวกันจำนวนมากให้หลาย ๆ ส่วนทำพร้อมกันได้

สำหรับ AI ที่เน้นการประมวลผลข้อมูลจำนวนมากในลักษณะที่ซ้ำซ้อนและเป็นแบบขนาน GPU จึงเป็นสถาปัตยกรรมที่ลงตัวอย่างสมบูรณ์แบบ เพราะมันสามารถทำงาน "ง่าย ๆ ซ้ำ ๆ หลาย ๆ ครั้งพร้อมกัน" ได้เร็วกว่า CPU หลายเท่าตัว ทำให้การฝึกอบรมโมเดล AI ที่มีขนาดใหญ่และซับซ้อนใช้เวลาลดลงจากหลายวันเหลือเพียงไม่กี่ชั่วโมง นี่คือหัวใจสำคัญที่ทำให้ GPU เป็นขุมพลังที่ขาดไม่ได้ในโลกของปัญญาประดิษฐ์ยุคใหม่

จากความต้องการด้าน AI นี่เอง NVIDIA ผู้ที่ผลิต GPU มาตั้งแต่ต้น จึงได้กลายมาเป็นผู้นำด้าน Hardware ไปในทันที กลายเป็นบริษัทที่มีอัตราเติบโตอย่างก้าวกระโดด เพราะ GPU ของ NVIDIA กลายเป็นที่ต้องการอย่างมาก

ในเมื่อ AI ต้องการ GPU แล้วทำไม GPU Radeon ของ AMD ถึงไม่เป็นที่ต้องการ?

คำตอบคือ สิ่งที่เรียกว่า CUDA

CUDA คือแพลตฟอร์มและ API (Application Programming Interface) ที่ช่วยให้นักพัฒนาสามารถเขียนโปรแกรมเพื่อใช้ประโยชน์จากพลังการประมวลผลแบบขนานของ GPU NVIDIA ได้อย่างง่ายดายและมีประสิทธิภาพ

และด้วยการพัฒนา CUDA มาอย่างยาวนานของ NVIDIA ทำให้มีนักพัฒนาจำนวนมหาศาลใช้ CUDA มีไลบรารี (libraries) และเฟรมเวิร์ค (frameworks) ยอดนิยมสำหรับ AI เช่น TensorFlow, PyTorch ถูกสร้างและปรับแต่งมาให้ทำงานได้ดีที่สุดบน CUDA และ GPU ของ NVIDIA เป็นหลัก นี่สร้าง "Network Effect" หรือ "Lock-in Effect" ที่แข็งแกร่งมาก

ถึงแม้ AMD ที่เพิ่งจะเบียดคู่แข่งตลอดกาลอย่าง Intel มา แต่การสร้างระบบนิเวศด้าน AI ที่ชื่อว่า ROCm (Radeon Open Compute platform) นั้นยังช้ากว่าและยังไม่เติบโตเท่า CUDA ทำให้มีนักพัฒนาน้อยกว่า ไลบรารีไม่สมบูรณ์เท่า และการโยกย้ายโปรเจ็กต์จาก CUDA มา ROCm ก็ไม่ใช่เรื่องง่ายสำหรับนักพัฒนา

และ NVIDIA ไม่เพียงแค่มี GPU ที่ประมวลผลกราฟิกเก่ง แต่ยังลงทุนในการออกแบบ Hardware เพื่อ AI โดยเฉพาะอย่าง Tensor Cores แกนประมวลผลเฉพาะทางที่ออกแบบมาเพื่อเร่งการคำนวณเมทริกซ์ (Matrix Multiplication) ที่เป็นหัวใจของการเรียนรู้เชิงลึก (Deep Learning) โดยเฉพาะ ทำให้การฝึกโมเดล AI รวดเร็วขึ้น และยังใช้หน่วยความจำแบบ HBM (High Bandwidth Memory) ใน GPU ระดับ Data Center ซึ่งจำเป็นอย่างยิ่งในการป้อนข้อมูลจำนวนมหาศาลให้กับคอร์ประมวลผลของ AI ได้อย่างรวดเร็ว ส่วน AMD นั้นยังไม่มี Hardware ที่เทียบเท่าและมีประสิทธิภาพเท่า Tensor Cores ในตลาด AI จึงยิ่งทำให้ NVIDIA เป็นผู้นำด้าน Hardware ในยุค AI อย่างไร้คู่เทียบ